Humans of Electrical Engineering, Mathematics and Computer Science

Said Hamdioui

Er is eerder behoefte aan een revolutie dan een evolutie in Computer Engineering

Said Hamdioui van de afdeling Computer Engineering van TU Delft is onlangs benoemd tot hoogleraar Dependable and Emerging Computer Technologies aan de faculteit Elektrotechniek, Wiskunde en Informatica. Hij presenteert ons zijn heldere kijk op de uitdagingen waarmee zijn onderzoeksveld wordt geconfronteerd, en vertelt welke aanpak en middelen nodig zijn om die uitdagingen aan te gaan. Zijn werk omvat twee onderzoekslijnen: (1) betrouwbaarheid en (2) nieuwe computerparadigma’s op basis van nieuwe technologieën in apparaten.

Betrouwbaarheid

Said: “Als gevolg van de voortdurende schaalvergroting van het veld, de globalisering van de productieketen van geïntegreerde schakelingen (IC’s) en het internet of things (IoT, in netwerken verbonden apparaten), wordt het betrouwbaarheidonderzoek van de toekomst bepaald door grote uitdagingen, met name in verband met beveiliging, toetsbaarheid en betrouwbaarheid.”

Beveiliging: “De bedreigingen zullen waarschijnlijk in omvang toenemen en meer verschillende vormen aannemen doordat steeds grotere aantallen services online beschikbaar zijn en cybercriminelen steeds geavanceerder te werk gaan in hun kat-en-muisspel met de beveiligingsexperts. Het gebruik van de cloud en datacentra, de ontwikkeling van het IoT en de globalisering van de IC-productieketen zullen waarschijnlijk tot nieuwe online gevaren leiden omdat al deze aspecten de cybercriminelen nieuwe mogelijkheden bieden. Er is dringend behoefte aan onderzoek naar solide verdedigingsstrategieën, niet alleen tegen bekende soorten aanvallen maar ook tegen onbekende soorten die hackers in de toekomst kunnen ontwikkelen. En dat niet alleen op softwareniveau, zoals tegenwoordig gebeurt, maar ook op het niveau van hardware. De oplossingen moeten end-to-end zijn (van de sensor tot en met de actuators en de cloud), met een kritieke rol voor de hardwarebeveiliging. Beveiligingsintelligentie (design-for-security) op chipniveau moet worden geïntegreerd in elk verbonden object (beveiligde opslag, smart data, beveiligde verwerking, beveiligde communicatie, enzovoort) en de run-time samenwerking van alle on-chipcomponenten en alle verbonden objecten moet eveneens geïntegreerd zijn.”

Beveiliging: “De bedreigingen zullen waarschijnlijk in omvang toenemen en meer verschillende vormen aannemen doordat steeds grotere aantallen services online beschikbaar zijn en cybercriminelen steeds geavanceerder te werk gaan in hun kat-en-muisspel met de beveiligingsexperts. Het gebruik van de cloud en datacentra, de ontwikkeling van het IoT en de globalisering van de IC-productieketen zullen waarschijnlijk tot nieuwe online gevaren leiden omdat al deze aspecten de cybercriminelen nieuwe mogelijkheden bieden. Er is dringend behoefte aan onderzoek naar solide verdedigingsstrategieën, niet alleen tegen bekende soorten aanvallen maar ook tegen onbekende soorten die hackers in de toekomst kunnen ontwikkelen. En dat niet alleen op softwareniveau, zoals tegenwoordig gebeurt, maar ook op het niveau van hardware. De oplossingen moeten end-to-end zijn (van de sensor tot en met de actuators en de cloud), met een kritieke rol voor de hardwarebeveiliging. Beveiligingsintelligentie (design-for-security) op chipniveau moet worden geïntegreerd in elk verbonden object (beveiligde opslag, smart data, beveiligde verwerking, beveiligde communicatie, enzovoort) en de run-time samenwerking van alle on-chipcomponenten en alle verbonden objecten moet eveneens geïntegreerd zijn.”

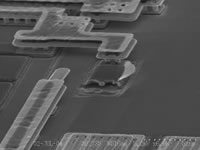

Toetsbaarheid en betrouwbaarheid: “Technologische trends, zoals afname van de betrouwbaarheid en stijging van de kosten en complexiteit als gevolg van schaalvergroting, en de enorme druk op het bedrijfsleven, bijvoorbeeld vanwege de time-to-market, leiden tot een nieuwe definitie van de ontwerp-, productie-, toetsbaarheids- en betrouwbaarheidsparadigma’s van IC’s. Wil de IC-sector zich staande kunnen houden, dan moeten we betrouwbare systemen ontwerpen die gebruik kunnen maken van onbetrouwbare apparaten en componenten. Daarom zijn op dit moment de juiste tests, toetsbaarheidsontwerpen en -methoden en fouttoleranties bij IC-systeemintegratie ten behoeve van levensduurverlenging en storingsreductie zulke gewilde onderzoeksthema's. Zelfbeherende betrouwbare systemen waarin testen en detectie, diagnose en karakterisering on-the-fly (in runtime) plaatsvinden met online reparatie en herstel, zijn de enige hoop voor de toekomst als we technologieën onder 20 nm willen toepassen in kritieke applicaties zoals de auto-industrie, gezondheidszorg, defensie, enzovoort. Bovendien vereisen nieuwe computertechnologieën zoals resistive computing and quantum computing door hun aard – die afwijkt van die van ‘gewone’ digital computing – radicaal nieuwe toetsmethoden. We hebben nieuwe foutenmodellen, testalgoritmen, toets-, diagnose-, rendements- en tolerantieontwerpen nodig, en nog veel meer.”

Toetsbaarheid en betrouwbaarheid: “Technologische trends, zoals afname van de betrouwbaarheid en stijging van de kosten en complexiteit als gevolg van schaalvergroting, en de enorme druk op het bedrijfsleven, bijvoorbeeld vanwege de time-to-market, leiden tot een nieuwe definitie van de ontwerp-, productie-, toetsbaarheids- en betrouwbaarheidsparadigma’s van IC’s. Wil de IC-sector zich staande kunnen houden, dan moeten we betrouwbare systemen ontwerpen die gebruik kunnen maken van onbetrouwbare apparaten en componenten. Daarom zijn op dit moment de juiste tests, toetsbaarheidsontwerpen en -methoden en fouttoleranties bij IC-systeemintegratie ten behoeve van levensduurverlenging en storingsreductie zulke gewilde onderzoeksthema's. Zelfbeherende betrouwbare systemen waarin testen en detectie, diagnose en karakterisering on-the-fly (in runtime) plaatsvinden met online reparatie en herstel, zijn de enige hoop voor de toekomst als we technologieën onder 20 nm willen toepassen in kritieke applicaties zoals de auto-industrie, gezondheidszorg, defensie, enzovoort. Bovendien vereisen nieuwe computertechnologieën zoals resistive computing and quantum computing door hun aard – die afwijkt van die van ‘gewone’ digital computing – radicaal nieuwe toetsmethoden. We hebben nieuwe foutenmodellen, testalgoritmen, toets-, diagnose-, rendements- en tolerantieontwerpen nodig, en nog veel meer.”

Nieuwe computertechnologieën

Said: “De tegenwoordige en opkomende applicaties zijn extreem veeleisend met betrekking tot opslagruimte en rekenkracht. Bigdata-applicaties en het IoT gaan de toekomst veranderen. Ze zullen alle aspecten van ons leven raken en ook de IC- en computerwereld op zijn kop zetten. Nieuwe applicaties vereisen de rekenkracht die kenmerkend was voor de supercomputers van een paar jaar geleden, maar hebben de beperkingen (grootte, energieverbruik en gegarandeerde responstijd) die typerend zijn voor embedded applicaties. De huidige computerarchitecturen en de technologieën die worden gebruikt om ze te bouwen, staan voor enorme uitdagingen, met andere woorden: ze kunnen niet de vereiste functionaliteiten en mogelijkheden bieden. Als we willen dat computersystemen in de nabije toekomst duurzame voordelen blijven opleveren, zullen we alternatieve computerarchitecturen en -concepten moeten onderzoeken in het licht van nieuwe device-technologieën. Computation-in-memory en neuromorphic computing zijn voorbeelden van alternatieve computerconcepten, terwijl memristive devices opkomende technologieën belichamen die dergelijke computerparadigma's potentieel mogelijk maken.”

Computation-in-memory (CIM): “De CIM-architectuur is een door ons ontwikkelde fundamentele doorbraak in de computerarchitectuur, bedoeld om de processoren en het geheugen op dezelfde fysieke locatie te integreren. Dit houdt in dat het vereiste werkgeheugen zich niet, zoals bij andere moderne computers, in de cache bevindt, maar naar de processorkern wordt verplaatst. CIM zorgt voor een aanzienlijke reductie van de barrière tussen geheugen en communicatie in de hedendaagse computerarchitectuur, levert een enorme schaalbare bandbreedte op, lijdt vrijwel niet aan lekken en maakt grootschalige parallelle verwerking mogelijk. Deze doorbraak lost in potentie de problemen van data-intensieve applicaties in enkele minuten op, in plaats van in enkele dagen (of in het ergste geval nooit). Dit betekent een grote stap op weg naar de ontwikkeling van schaalbaar ultralaag vermogen in computergeheugenarchitecturen voor zowel data-intensieve applicaties als applicaties met laag vermogen zoals IoT-devices (bijvoorbeeld wearables). Ons doel is nu het aantonen van het reusachtige potentieel van deze architectuur.”

Computation-in-memory (CIM): “De CIM-architectuur is een door ons ontwikkelde fundamentele doorbraak in de computerarchitectuur, bedoeld om de processoren en het geheugen op dezelfde fysieke locatie te integreren. Dit houdt in dat het vereiste werkgeheugen zich niet, zoals bij andere moderne computers, in de cache bevindt, maar naar de processorkern wordt verplaatst. CIM zorgt voor een aanzienlijke reductie van de barrière tussen geheugen en communicatie in de hedendaagse computerarchitectuur, levert een enorme schaalbare bandbreedte op, lijdt vrijwel niet aan lekken en maakt grootschalige parallelle verwerking mogelijk. Deze doorbraak lost in potentie de problemen van data-intensieve applicaties in enkele minuten op, in plaats van in enkele dagen (of in het ergste geval nooit). Dit betekent een grote stap op weg naar de ontwikkeling van schaalbaar ultralaag vermogen in computergeheugenarchitecturen voor zowel data-intensieve applicaties als applicaties met laag vermogen zoals IoT-devices (bijvoorbeeld wearables). Ons doel is nu het aantonen van het reusachtige potentieel van deze architectuur.”

Neuromorphic computing: “Het basisidee van neuromorphic computing is dat we gebruikmaken van het enorme parallelisme van dergelijke schakelingen om informatieverwerkingssystemen met laag vermogen en geringe fouttolerantie te maken. Dat levert alternatieve methoden voor de opbouw van (embedded) artificial intelligence op. De uitdaging is nu om nieuwe architecturen voor nano-elektronische systemen zo te begrijpen, ontwerpen, bouwen en gebruiken dat ze de beste aan de hersenen ontleende informatieverwerkingsconcepten combineren met nanotechnologische hardware, inclusief de algoritmen en hun architecturen.”

Neuromorphic computing: “Het basisidee van neuromorphic computing is dat we gebruikmaken van het enorme parallelisme van dergelijke schakelingen om informatieverwerkingssystemen met laag vermogen en geringe fouttolerantie te maken. Dat levert alternatieve methoden voor de opbouw van (embedded) artificial intelligence op. De uitdaging is nu om nieuwe architecturen voor nano-elektronische systemen zo te begrijpen, ontwerpen, bouwen en gebruiken dat ze de beste aan de hersenen ontleende informatieverwerkingsconcepten combineren met nanotechnologische hardware, inclusief de algoritmen en hun architecturen.”