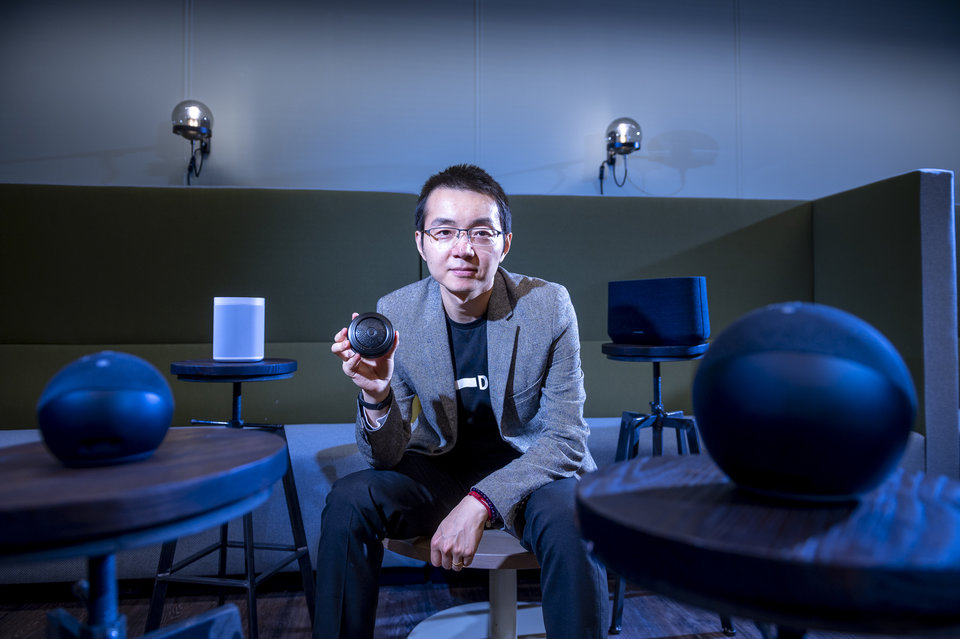

De razendsnelle ontwikkeling van kunstmatige intelligentie brengt ook nieuwe uitdagingen met zich mee. Andreia Martinho probeert met haar PhD de übertheoretische wereld van de ethiek en de praktijk van kunstmatige intelligentie dichter bij elkaar te brengen.

Voortschrijdende technologie maakt ons dagelijks leven op verschillende vlakken een stuk eenvoudiger. Dankzij kunstmatige intelligentie (AI) kunnen we communiceren met apparaten, ingewikkelde handelingen uitvoeren en komen we sneller van A naar B. Tegelijkertijd zitten aan technologie aspecten waarbij machine (nog) het onderspit delft ten opzichte van de mens. Onder andere als het gaat om ethiek.

Het complexe domein van ethische AI

Martinho kwam in 2018 naar de TU Delft voor haar PhD over ethiek en AI. “De ontwikkeling van kunstmatige intelligentie gaat de laatste jaren razendsnel. Nu we als maatschappij vaker met AI te maken hebben, worden ethische vraagstukken steeds belangrijker om ongewenste effecten te voorkomen. Je wilt niet dat AI systemen zoals voertuigen of robots handelingen verrichten die wij als mensen onwenselijk vinden.”

Maar hoe zorg je daar dan voor? "Er zijn twee manieren om hiernaar te kijken: of je neemt moraliteit op in het systeem, of je creëert een heleboel regels en voorschriften om ervoor te zorgen dat deze systemen onder controle blijven."

Moraliteit in kunstmatige intelligentie

In een artikel dat Martinho recent publiceerde, ondervroeg zij ethici over kunstmatige moraliteit. Ze was verrast door de rijkdom en diversiteit aan zienswijzen die ze in vijf verschillende groepen categoriseerde. "Sommige ethici zijn van mening dat kunstmatige moraliteit de sleutel is tot een beter begrip van moraliteit en dat deze systemen betere morele agenten zullen zijn dan mensen, terwijl anderen van mening zijn dat ze een existentiële bedreiging vormen." Ze hoopt dat een dergelijke ordening een goede basis vormt voor toekomstige debatten onder ethici.

Volgens Martinho zijn Artificial Moral Agents (AMA’s), systemen die moreel redeneren, voorlopig nog toekomstmuziek. “Het gaat echt nog in babystapjes. We moeten ook nog debatten voeren over hoe ver de autonomie van AI mag reiken en wie uiteindelijk verantwoordelijk is voor de handeling van een autonoom apparaat of voertuig.”

Over het inpassen van moraliteit in deze systemen legt Martinho uit dat er verschillende benaderingen zijn en dat onderzoekers het niet eens zijn over welke de beste benadering is. In een van haar projecten koos ze voor de benadering van morele onzekerheid. “Zo’n AMA-systeem bepaalt niet zozeer wat goed of fout is, maar maakt een keuze op basis van een zekere mate van moreel redeneren die rekening houdt met verschillende morele theorieën." Martinho legt verder uit dat, zelfs als kunstmatige moraliteit niet wordt gerealiseerd, dit soort onderzoek onderzoekers wel in staat stelt veel over moraliteit te leren.

Tegelijkertijd blijft de ethische wetenschap vooral hangen in gedachte-experimenten, zag Martinho. “Ethici kijken vooral naar speculatieve scenario’s; extreme situaties die in de praktijk vrijwel nooit voorkomen. Dat maakt het voor AI-producenten lastig om ze te vertalen naar de realiteit.”

Bedrijfsleven en academische wereld moeten samenwerken aan ethische AI

Toen Martinho nader onderzoek deed naar zelfrijdende voertuigen, viel haar op dat het trolley probleem zo’n dominante rol speelde in de ethische literatuur. Bij het trolleyprobleem ontstaat de situatie dat het maken van slachtoffers onvermijdelijk is. Bijvoorbeeld wanneer een zelfrijdende auto afkoerst op een oudere vrouw, maar wanneer het van richting verandert een moeder met baby zal aanrijden. Welke keuze moet het voertuig dan maken? “Ik begrijp dat het best fascinerend is om een theoretisch gedachte-experiment ineens tot leven te zien komen, maar ik vond dat de gesprekken over ethiek niet alleen tot dit gedachte-experiment beperkt moesten blijven”. De focus op deze theoretische ideeën zonder technologische input vanuit AI-ontwikkelaars zorgt ervoor dat producenten zich minder betrokken voelen bij de ethische discussie. Tegelijkertijd is er zonder hun inbreng een groter risico op speculatieve ethiek.

AI industrie betrekken

Martinho wilde daarom de AI producent betrekken in het gesprek. "Toen ik literatuuronderzoek deed, vond ik dat er een belangrijk stuk ontbrak in deze complexe puzzel: wat is de mening van de industrie over de ethiek van AV's?" Ze onderzocht vervolgens de rapporten van producenten van autonome voertuigen met vergunningen in Californië en kwam tot de conclusie dat het trolleyprobleem nooit in deze rapporten werd genoemd.

Het trolleyprobleem is niet bedoeld om door de industrie te worden opgelost, benadrukt Martinho, maar om producenten van autonome voortuigen bewust te maken van de mogelijkheid van dit soort extreme situaties. “Veel AI-producenten vinden het trolleyprobleem zo hypothetisch, dat ze het niet serieus nemen.”

Daarom is het belangrijk om een evenwicht te vinden. “Ethici onderzoeken extreme situaties met sterk vereenvoudigde theoretische modellen om zaken als morele gevoelens en normen en waarden te testen. Deze theorieën moeten door de industrie niet blindelings worden overgenomen, maar ook niet worden afgewezen. De industrie zal rekening moeten houden met risico’s in extreme verkeerssituaties, anders vertrouwt de consument de technologie niet."

Rol van maatschappij en beleidsmakers

Naast de industrie en wetenschap spelen ook de maatschappij en beleidsmakers een rol bij de ontwikkeling van ethiek in technologie, vervolgt Martinho. “Voor producenten is het belangrijk om duidelijke kaders en richtlijnen te hebben over ethiek in AI.”

Die kaders worden onder meer bepaald door het maatschappelijk debat. Daarin gaat het bijvoorbeeld over de vraag tot hoe ver technologie mag ingrijpen in ons dagelijks leven. Martinho: “Vervolgens is het aan beleidsmakers om die opvattingen te vertalen naar beleid en wetgeving. Het integreren van ethiek in AI is dus echt een samenspel tussen de wetenschap, industrie, maatschappij en overheden.”

Liefde voor complexe vraagstukken

Martinho noemt zichzelf als onderzoeker een problem solver. Voor haar kan een vraagstuk niet complex genoeg zijn. De diversiteit aan opvattingen binnen de ethiek en de kloof tussen AI en ethiek ziet ze dan ook niet als probleem, maar als rijkdom. “Het is aan mij om daar structuur en samenhang in aan te brengen. Door het in kleine stukjes op te delen en het behapbaar te maken, kunnen overheden en bedrijven er in de praktijk mee aan de slag. Uiteindelijk helpt dat de maatschappij als geheel weer verder.”

Bruggenbouwer

Martinho maakt met haar PhD onderdeel uit van de door ERC gesubsidieerde BEHAVE programma, waar professor Caspar Chorus aan het hoofd staat. Deze onderzoeksgroep zet zich in om nieuwe morele keuzemodellen te ontwikkelen en in experimenten te testen. Ze vindt het een privilege om in BEHAVE te werken. “Het onderzoekswerk en werkomgeving zijn extreem positief en interessant door het interdisciplinaire en diverse team. In de onderzoeksgroep voelt ze zich een schakel tussen de groepsleden die aan de theoretische moraliteitsprojecten werken en de wiskundige modelleurs. “Ik doe empirisch onderzoek in ethiek van AI wat betekent dat mijn dag vaak is opgesplitst in het lezen van filosofische artikelen en het werken met programmeertaal Python.”

Voordat ze naar de TU Delft kwam, werkte Martinho een paar jaar op de ethiek afdeling van een groot bedrijf in de gezondheidszorg in de VS. In plaats van haar tijd in het bedrijfsleven als nadelig te beschouwen, nam ze deze ervaring juist mee in haar onderzoek. "Ik wist dat mijn onderzoeksvaardigheden wat roestig waren in vergelijking met die van mijn collega's, maar in plaats van me daardoor te laten beïnvloeden, besloot ik mijn vaardigheden en kennis in te zetten in dit nieuwe hoofdstuk van mijn leven."

Als bruggenbouwer hoopt Martinho met haar PhD meer toenadering en wederzijds begrip te creëren. “Ik hoop dat zowel ethici als AI ontwikkelaars in de toekomst betrokken zijn ethische discussies over AI. Nu nog zorgen dat ze elkaar ook in het veld weten te vinden.”