Robots die leren als mensen

In de afgelopen jaren verschenen in de media talloze berichten vol zorgen en zelfs angsten over robots en kunstmatige intelligentie: angst dat robots al onze banen inpikken (minister Asscher in 2014), angst dat kunstmatige intelligentie de mens overvleugelt en in gevaar brengt (natuurkundige Stephen Hawking en ondernemer Elon Musk). Tegelijkertijd zagen we indrukwekkende filmpjes van bijvoorbeeld de robots van het Amerikaanse bedrijf Boston Dynamics: robot Big Dog die in de sneeuw een helling op loopt, en de mensachtige, tweebenige robot Atlas die over obstakels springt en een salto achterover maakt.

In het afgelopen decennium zijn robots inderdaad steeds beter geworden in het leren van nieuwe taken, een essentieel onderdeel van intelligentie. Robots kunnen hun omgeving veel beter waarnemen, wat heeft geleid tot slimmere robotarmen en ook een krachtige steun in de rug is voor de ontwikkeling van autonome voertuigen. Pas wanneer robots ook overweg kunnen met ongestructureerde omgevingen en onvoorziene omstandigheden, kunnen we ze overal in het dagelijks leven integreren.

Toch is het lerende vermogen van robots nog steeds veel minder dan dat van mensen. Mensen zijn flexibeler, leren van minder voorbeelden en kunnen een groot aantal verschillende taken leren, van het leren van een nieuwe taal tot leren skiën.

Robots laten leren is veel moeilijker dan computers laten leren

Maar hoe ontwikkelt de robotica zich nu eigenlijk en wat is de laatste stand van zaken? Hoogleraar intelligente controle en robotica Robert Babuska van de afdeling Cognitieve Robotica van de faculteit ME onderzoekt hoe robots beter kunnen leren.

Babuska: “Sommige filmpjes met robots zijn in de eerste plaats PR-filmpjes, filmpjes voor de show. Wat ze niet laten zien, is dat hun robots eenmalig een bepaald kunstje hebben vertoond. Alle keren dat de robot omviel, laten ze je niet zien. En het kunstje lukt alleen maar als de omgeving perfect is voorbereid. Leg een balk anders neer, dim het licht een beetje en de robot valt om. De filmpjes laten je geloven dat een bepaald probleem is opgelost, maar dat is onzin. Dat wat je ziet generaliseert niet naar andere omstandigheden.”

Wat zou er dan moeten gebeuren om de perceptie bij een breed publiek realistischer te maken?

Babuska: “Als robotici moeten we eerlijker zijn over wat robots wel en niet kunnen. Er is te veel overselling, in de VS vaak nog sterker dan in Europa. Telkens wanneer we spreken met journalisten of zelf een lezing geven, moeten we duidelijk maken hoe complex het is om een robot goed in de wereld te laten opereren. Daarnaast vind ik ook dat er te veel angst is. Je kunt talloze drone-filmpjes vinden die je bang maken voor een toekomst met drones. Maar Drones kunnen juist veel nuttige dingen doen.”

“Hetzelfde geldt voor robots op de grond. Er zijn zoveel uitdagingen in de maatschappij waar robots kunnen bijdragen aan een oplossing. Er is nog zoveel saai, smerig en gevaarlijk werk dat we beter aan robots kunnen overlaten. In de bouwsector en in de steigerbouw zijn maar weinig arbeiders die zonder versleten rug hun pensioen halen. Of kijk naar mensen die in de voedingsindustrie de hele dag in een temperatuur van zeven graden dezelfde handeling uitvoeren. Dat is toch een beeld dat eerder bij het jaar 1900 past dan bij 2020. Ik wil er graag aan bijdragen dat robots ons gaan helpen bij al dat soort taken.”

Babuska: “Ik richt me daarbij vooral op robots die goed leren bewegen. Het maakt me niet uit of het gaat om lopen, rijden, varen, vliegen of om het beetpakken en verplaatsen van voorwerpen. Ik onderzoek algemene technieken die voor een diverse toepassingen bruikbaar zijn in plaats van slechts voor één specifieke toepassing.”

Toen de deep learning-revolutie zich voltrok, bleek al snel dat robotici niet zomaar een beeldherkenningsalgoritme van een computer in een robot kunnen stoppen en verwachten dat het dan goed werkt. Een robot is meer dan een computer, het is een computer gekoppeld aan een fysiek lichaam. Een robot heeft een fysieke interactie met zijn omgeving. Babuska: “Een robot die beweegt, ziet de wereld steeds iets anders. En hij moet in real-time snel beslissingen nemen die ook nog nauwkeurig en betrouwbaar zijn. Als de robot een fout maakt, is dat in de fysieke wereld veel kostbaarder dan in de virtuele wereld. Dat zijn allemaal aspecten die het extra moeilijk maken om robots goed te laten leren.”

Als robotici moeten we eerlijker zijn over wat robots wel en niet kunnen.

Grote uitdagingen voor lerende robots

- Werken in ongestructureerde omgevingen

- Omgaan met onvoorziene omstandigheden

- Leren van weinig voorbeelden

- Gezond verstand (achtergrondkennis over de wereld)

- Leervermogen generaliseren naar andere omstandigheden

- Leervermogen opgedaan in het ene domein ook benutten in een ander domein (transversaal leren)

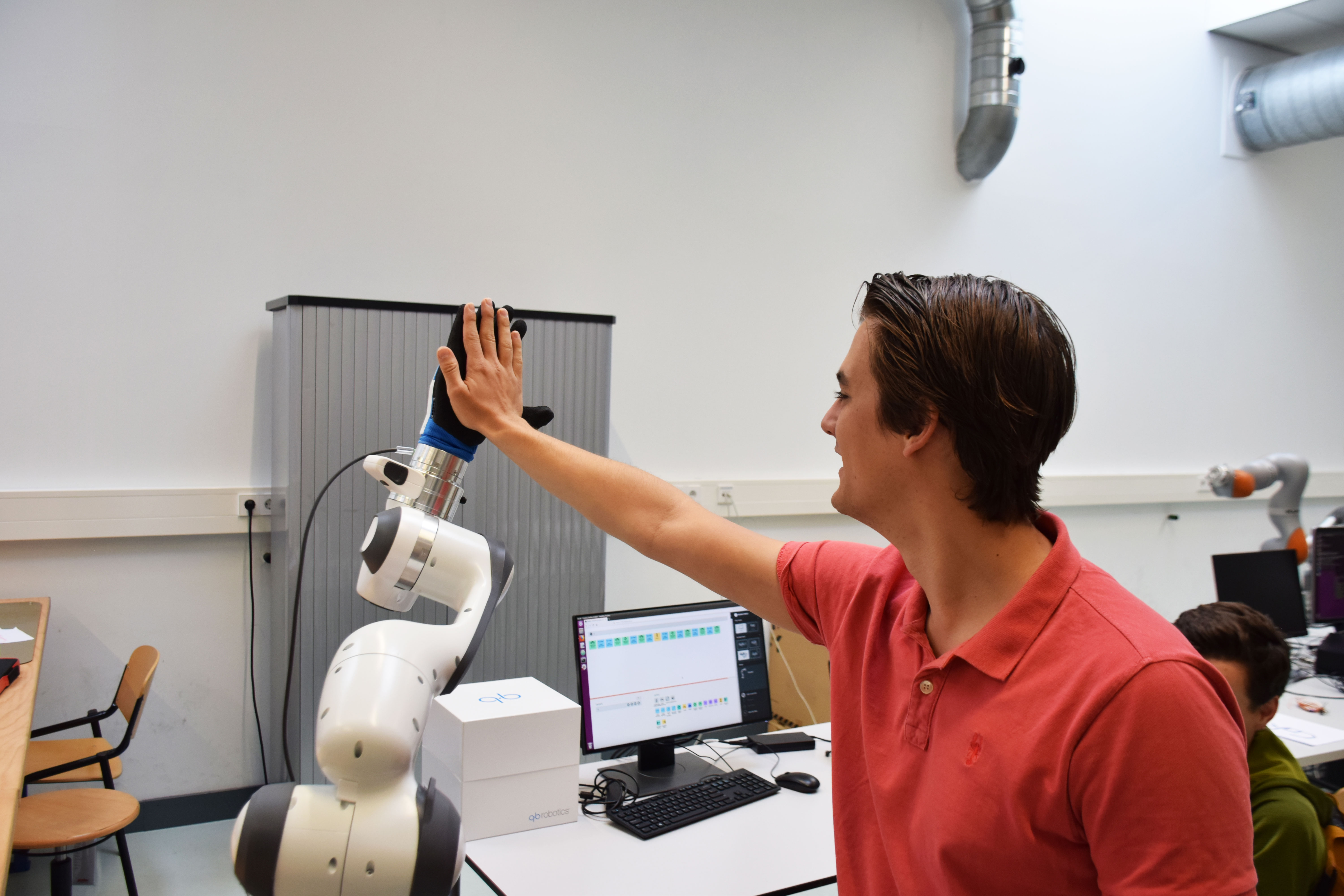

- Intelligente interactie met mensen

- Creativiteit

Leren met behulp van beloning en straf

Grofweg kunnen robots op drie manieren nieuwe dingen leren: geheel onder supervisie, geheel zonder supervisie, of ergens tussen die twee uitersten in. Bij het leren onder supervisie leert de robot doordat een mens direct of indirect als instructeur optreedt en de robot laat weten welke actie in welke situatie juist is. Deze manier van leren is het verst ontwikkeld. Bij leren zonder supervisie moet de robot alles zelf uitzoeken. Deze vorm van leren is het moeilijkst en staat pas in de kinderschoenen.

Een manier van leren die tussen beide uitersten in ligt, is het leren met behulp van beloning en straf. Dit is vergelijkbaar met de manier waarop ouders hun kinderen opvoeden. Het idee is dat de robot zich eerst op willekeurige manieren gedraagt en dat hij evalueert hoe succesvol elk van die gedragingen uitpakt. Dat kan op basis van feedback van een instructeur die zegt of de robot zijn actie goed heeft uitgevoerd. Bijvoorbeeld: lukt het de robot om een appel op te pakken of laat hij hem weer op de grond vallen? De robot probeert het een paar keer, kiest het succesvolste gedrag, brengt daar een aantal willekeurige variaties op aan en gaat opnieuw proefondervindelijk bepalen welke van die nieuwe gedragingen het meest succesvol is. Deze manier van leren heet reinforcement learning.

Babuska gebruikt een combinatie van deep learning en reinforcement learning, een techniek die deep reinforcement learning heet. Maar ook deze combinatie doet het weliswaar goed in eenvoudige, spelachtige omgevingen op een computer maar niet automatisch in de complexe wereld waarin robots zich bewegen.

Wat is dan de oplossing?

Babuska: “We hebben in de afgelopen jaren ontdekt dat we de robot niet moeten laten leren van het volledige beeld dat hij ziet, maar van een versimpelde werkelijkheid. Uit de beelden die de robot ziet, extraheren we kenmerken die nuttig zijn om de robot het juiste gedrag te laten vertonen. Die versimpelde werkelijkheid bestaat uit wat we state-representations noemen. Stel, een mobiele robot rijdt rond in een magazijn en moet op zoek naar een stellage waar een boormachine ligt. Dan moet de robot in de beelden die hij onderweg ziet de kenmerken van de stellage en de boormachine kunnen herkennen. Die kenmerken zitten dan in zo’n state representation. Maar wanneer er mensen ergens ver weg in het beeld lopen, en ze de robot niet hinderen, dan is dat niet belangrijk voor het halen van zijn doel. Die informatie hoeft de robot dan ook niet te verwerken.”

Het gevolg is dat de robot in plaats van miljoenen beeldjes misschien paar honderdduizend nodig heeft. Dat is precies zoals mensen ook niet alle visuele informatie die ze binnenkrijgen verwerken, maar vooral die informatie waarvan ze verwachten dat deze bijdraagt aan het halen van hun doel op dat moment.

Pleidooi voor een robotcrèche

Babuska neemt onder andere deel aan een Europees Project dat deep reinforcement learning voor robots verder probeert te verbeteren: Open Deep Learning Toolkit for Robotics (OpenDR). OpenDR wil demonstraties ontwikkelen van lerende robots in de gezondheidszorg, de landbouw en in de industriële productie.

En in het onderzoeksproject Cognitive Robots for Flexible Agro Food Technology (FlexCRAFT) richt Babuska zich samen met onderzoekers van vijf universiteiten en vijftien bedrijven expliciet op toepassingen in de landbouw- en voedingsindustrie. Dit grote samenwerkingsverband maakt een alomvattende robotica-aanpak mogelijk waarin fundamentele robotvaardigheden als actieve waarneming, het modelleren van de buitenwereld, planning en controle, grijpen en manipulatie gecombineerd worden met praktische use-cases. Dan gaat het om use-cases voor kassen in de tuinbouw (bijvoorbeeld het verwijderen van bladeren en het plukken van fruit) en in de voedselverwerkende industrie (bijvoorbeeld het verwerken van pluimvee) en in de voedselverpakkende industrie.

Babuska: “We zitten met deep reinforcement learning echt nog in de onderzoeksfase. Er zijn mooie lab-experimenten van robots die met deze techniek voorwerpen beter kunnen grijpen en verplaatsen. Er is zelfs een robot die de Rubik-kubus razendsnel oplost met één hand. Maar de stap van het lab naar grootschalige praktische toepassingen zal nog wel even op zich laten wachten.”

Wanneer we lerende robots stukje bij beetje gaan zien in het alledaagse leven, dan kan het niet anders dat die robots af en toe fouten zullen maken. Hoe moeten we daarmee omgaan?

Babuska: “Als we mensen trainen op een werkplek, dan accepteren we bepaalde fouten. Eigenlijk zouden we dat bij robots ook moeten doen. We zouden een beginnende robot als een leerling moeten beschouwen. Misschien moeten we zelfs iets van een robotcrèche opzetten. Dat meen ik serieus. We zouden in een magazijn een aparte verpakkingslijn kunnen neerzetten waar robots fouten mogen maken voordat ze het echte werk gaan doen.”